بايت دانس تكشف عن نموذج INFP لتحويل الصور الثابتة إلى مقاطع فيديو تفاعلية باستخدام الذكاء الاصطناعي

أعلنت شركة بايت دانس، المالكة لتطبيق تيك توك، عن تطوير نموذج ذكاء اصطناعي جديد يحمل اسم INFP، يتيح تحويل الصور الشخصية الثابتة إلى مقاطع فيديو حية يظهر فيها الأفراد وكأنهم يتحدثون ويتفاعلون مع المدخلات الصوتية.

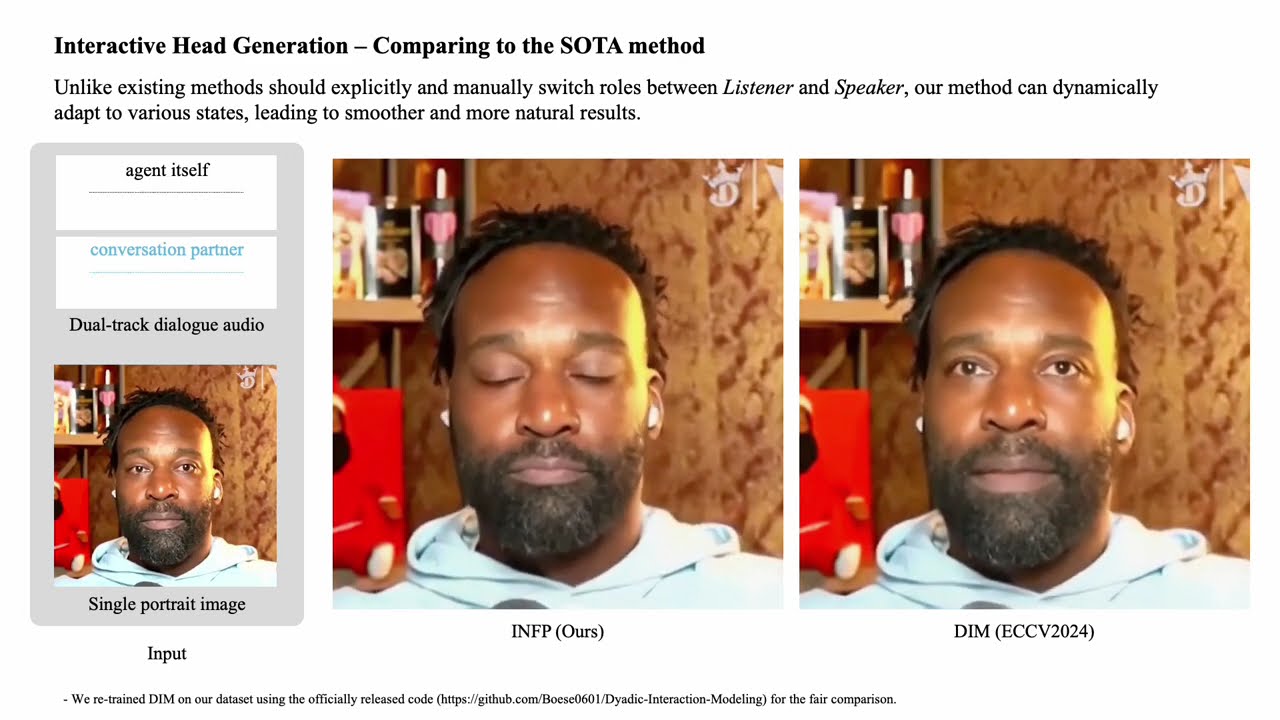

يتميز نموذج INFP بقدرته على توليد مقاطع فيديو لمحادثات واقعية بين شخصين دون الحاجة إلى تحديد الأدوار (التحدث أو الاستماع) يدويًا. حيث يعتمد النموذج على تحليل تدفق المحادثة ليحدد هذه الأدوار تلقائيًا، مما يسهم في خلق تجربة تفاعلية سلسة وواقعية.

ويتكون النظام من مرحلتين رئيسيتين:

في المرحلة الأولى، يتم محاكاة حركات الرأس عن طريق التقاط أدق التفاصيل من تعبيرات الوجه وحركات الرأس في مقاطع الفيديو وتحويلها إلى بيانات قابلة للاستخدام لتحريك الصور الثابتة.

أما المرحلة الثانية، فهي تشمل توليد الحركات استنادًا إلى الصوت، حيث يقوم النظام بتحليل الصوت لإنشاء أنماط حركة طبيعية تتناسب مع التحدث والاستماع، مع تعديل هذه الأنماط لتتوافق بشكل واقعي مع الصوت.

ولضمان دقة عالية، طورت بايت دانس قاعدة بيانات جديدة تُسمى DyConv، التي تحتوي على أكثر من 200 ساعة من المحادثات الحقيقية المجمعة من الإنترنت. وتتميز هذه القاعدة بقدرتها على التقاط طيف أوسع من المشاعر البشرية وبجودة فيديو أعلى مقارنة بقواعد البيانات الأخرى مثل ViCo وRealTalk.

وقد أكدت بايت دانس أن نموذج INFP يتفوق على الأدوات الحالية في مجالي مطابقة حركة الشفاه بالصوت والحفاظ على ملامح الوجه الطبيعية، بالإضافة إلى إنشاء حركات واقعية أثناء الاستماع.

وفي الوقت الذي يعتمد فيه النموذج حاليًا على الصوت فقط، تتطلع الشركة إلى تطويره ليتفاعل مع النصوص والصور أيضًا، بالإضافة إلى توسيع نطاقه ليشمل تحريك الجسم بالكامل بدلاً من الرأس فقط. ومع إدراكها للمخاطر المحتملة المرتبطة بإساءة استخدام هذه التقنية، أكدت بايت دانس أنها ستقتصر في الوقت الحالي على استخدام INFP في الأبحاث الأكاديمية.

ويعد هذا النظام جزءًا من استراتيجية الذكاء الاصطناعي لشركة بايت دانس، ويُتوقع أن تجد تطبيقات مثل تيك توك و CapCut التابعة لها في المستقبل المنصة المثالية لتوظيف هذه الابتكارات.